でも大人の勉強会は始まりました。

雨にも負けず、風にも負けず、頑張ります!

今日は、前回の続きです。

Archivematicaの機能とOAISを比較しながら、OAISに関する理解を深めます。

まずはこれから↓

ArchivematicaとOAIS参照モデルの対応関係(スライド49枚目)

https://www.slideshare.net/Archivematica/digital-preservation-with-archivematica-an-introduction

ちゃんと対応関係が出ています。49枚目のスライドがこれ↓

OAISでいう長期保存

1)技術の変化にデータが耐えられる(読める、証拠として機能する)

2)Consumerの立場で読めるようなデータでなければならない。利用者の要求に答えられるような形でなければならない。

以下はマゼンタブック(https://public.ccsds.org/pubs/650x0m2.pdf)で説明する3つのデータパッケージの関係です。この3つがContent Informationとなります。

このContent Informationは、さらにPDIと合わさってパッケージとなります。これにさらに、ISAD(G)などのようなDescrptive Informationが加わることになります。

PDI(Preservation Descriptive Informatiom)の要件(5つ)

- Reference Information:UUIDのような参照情報

- Context Information: Content Informationの関係をMETSに構造情報として記述する

- Provenance Information:データがどんなん出処からできてどんなふうに作成されたかを記述。PREMISの辞書を利用。

- Fixity Information:不変性、チェックサム

- Access Rights Infortmation:アクセス権限、PREMISに記述

このPDIはTransferからAIPが作成する過程で、どんどん情報が加わる。

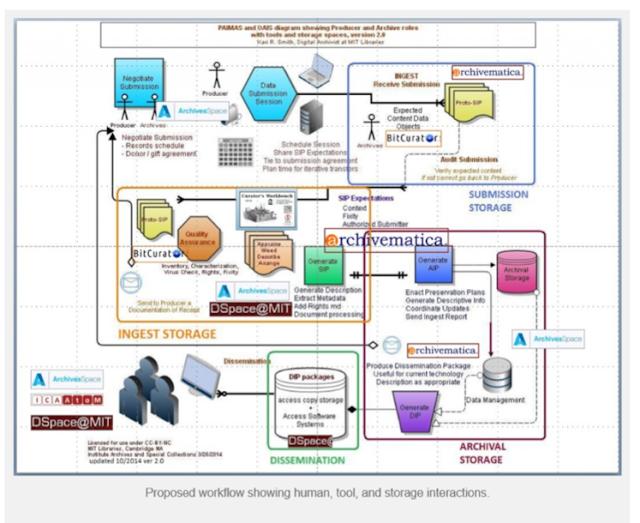

Archivematicaのシステム概念図↓

https://digitize.library.ubc.ca/digitizers-blog/how-we-digitize-digital-preservation-2/

Archivematicaの画面↓では、左側にmicro serviceというのがあって、各機能でどんな処理をしているかが表示されます。これはingestのときの画面です。

実は、いろいろ沢山メニューを勉強しましたが、全部かけませんでした。

まぁ、あとは各自資料を読むことですね。

今日のOAISの説明でガソリンなしで頑張ってくれたYoさんに感謝!パチパチパチ

===================================

次回は、2019年1月18日(金)です。

1)Archivemaiticaのpreservation planning, Access, Administration の機能

2)Pipelineについて

勉強します〜。皆様よいお年を!